Bài viết này thực hiện (hoặc lụm bài về đăng câu like từ các trang khác) bởi Việt Lâm Coder một YOUTUBER có tâm và đẹp trai siêu cấp vô địch zũ trụ. Các bạn đi ngang nếu được cho Lâm 1 like và 1 đăng ký kênh Youtube nhé !!

Bài viết này thực hiện (hoặc lụm bài về đăng câu like từ các trang khác) bởi Việt Lâm Coder một YOUTUBER có tâm và đẹp trai siêu cấp vô địch zũ trụ. Các bạn đi ngang nếu được cho Lâm 1 like và 1 đăng ký kênh Youtube nhé !!

Hãy đối mặt với thực tế: Các trợ lý lập trình AI như GitHub Copilot thì tuyệt vời, nhưng chi phí đăng ký của chúng có thể khiến bạn “cháy túi”. Giới thiệu DeepSeek R1—một mô hình ngôn ngữ mã nguồn mở miễn phí, cạnh tranh với GPT-4 và Claude 3.5 trong các nhiệm vụ lập luận và lập trình. Kết hợp nó với Cline, một plugin VS Code biến AI này thành một tác nhân lập trình hoàn chỉnh, và bạn đã có một thiết lập mạnh mẽ có khả năng viết, gỡ lỗi và thậm chí thực thi mã một cách tự động—tất cả mà không mất một xu nào.

Trong hướng dẫn này, tôi sẽ hướng dẫn bạn tất cả những gì bạn cần biết, từ cài đặt Cline đến tối ưu hóa DeepSeek R1 cho các dự án của bạn. Bắt đầu nào!

Điều gì làm cho DeepSeek R1 đặc biệt?

1. Miễn phí (Thật đấy!)

Khác với các mô hình độc quyền, DeepSeek R1 hoàn toàn là mã nguồn mở và có thể sử dụng thương mại. Không có giới hạn token, không phí ẩn—chỉ có sức mạnh AI thô.

2. Hiệu suất cạnh tranh với các mô hình trả phí

DeepSeek R1 vượt trội trong lập trình, toán học và lập luận logic. Ví dụ, biến thể 32B của nó vượt trội hơn mô hình o1-mini của OpenAI trong các tiêu chí tạo mã, và mô hình 70B của nó so sánh ngang bằng với Claude 3.5 Sonnet trong các nhiệm vụ phức tạp.

3. Tùy chọn triển khai linh hoạt

Chạy nó cục bộ để bảo mật và tốc độ, hoặc sử dụng API giá rẻ của DeepSeek (chỉ từ $0.01 cho mỗi triệu token) để truy cập đám mây.

Cài đặt DeepSeek R1 trong VS Code với Cline

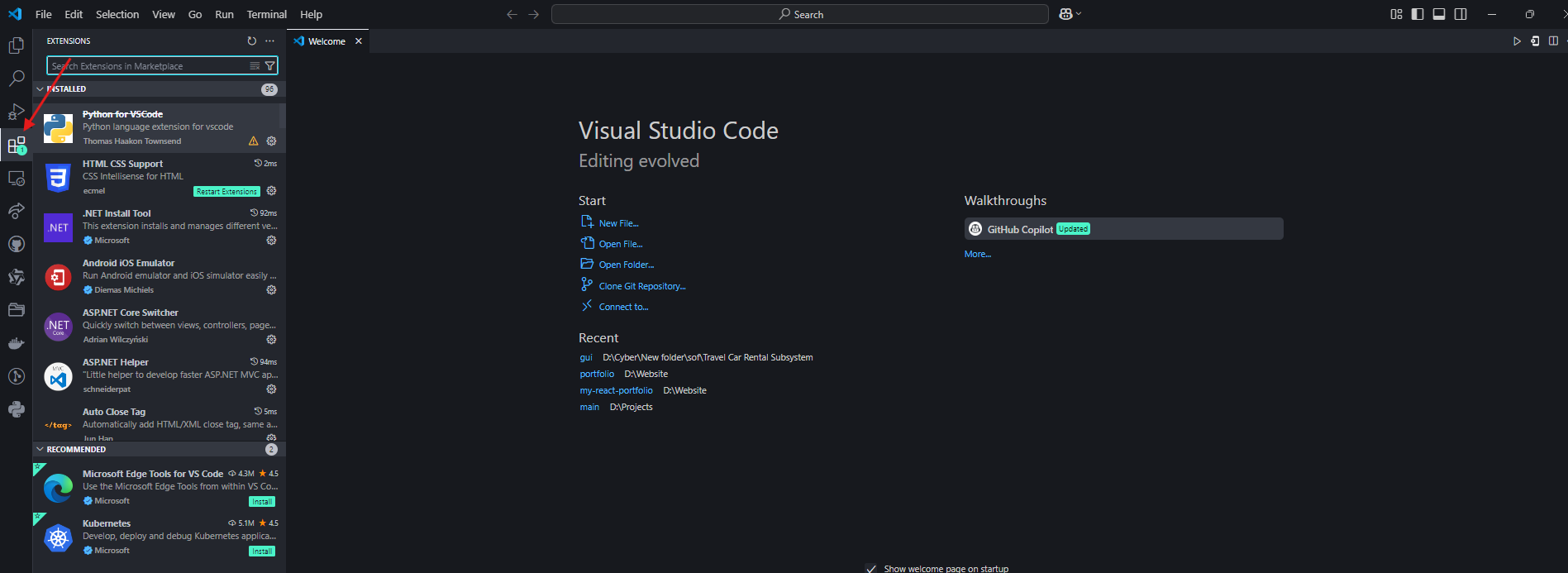

Bước 1: Cài đặt Plugin Cline

- Mở VS Code và điều hướng đến tab Mở rộng.

2. Tìm kiếm “Cline” và cài đặt nó.

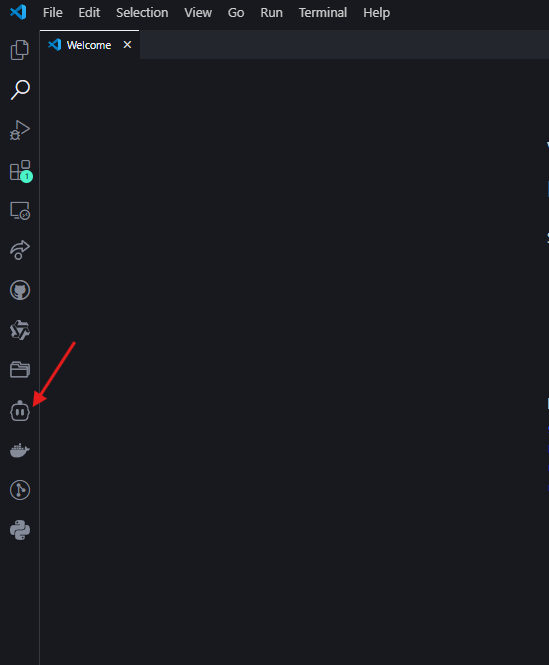

3. Nhấn vào biểu tượng robot trong thanh bên trái để kích hoạt Cline.

Bước 2: Chọn Quy trình làm việc DeepSeek R1 của bạn

Tùy chọn A: Thiết lập Cục bộ (Miễn phí, Bảo mật đầu tiên)

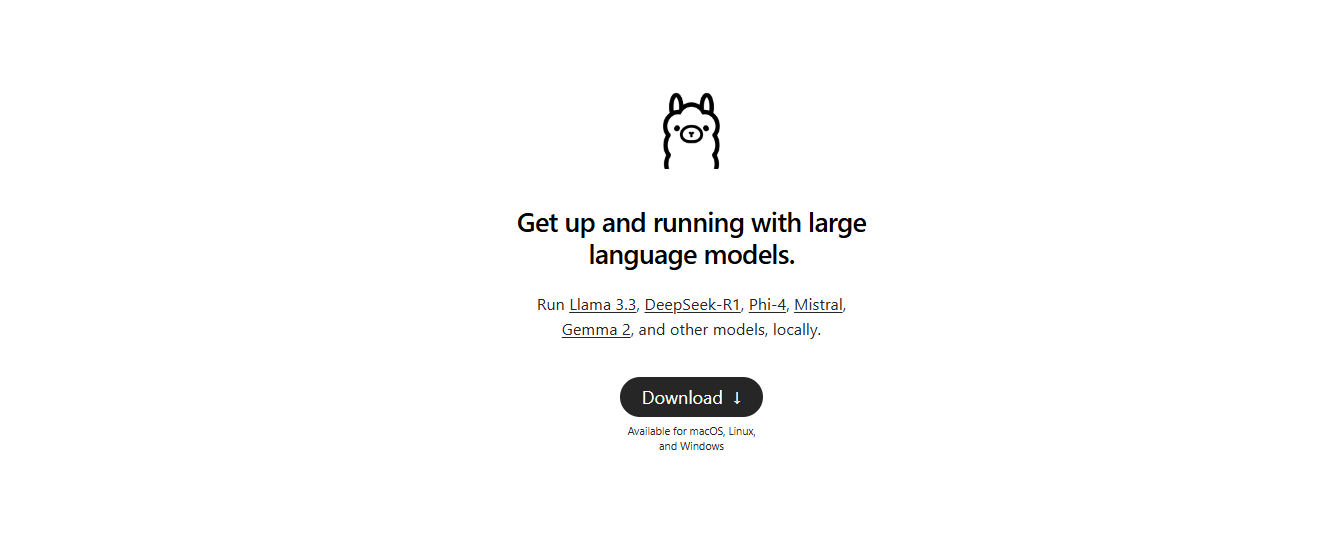

- Cài đặt Ollama: Tải xuống từ ollama.com để quản lý các mô hình AI cục bộ.

2. Kéo Mô hình: Trong terminal của bạn, chạy:

|

1 2 |

ollama pull deepseek-r1:14b # Đối với phần cứng tầm trung (ví dụ: RTX 3060) |

Các mô hình nhỏ hơn như 1.5b hoạt động cho các nhiệm vụ cơ bản, nhưng 14B+ được khuyến nghị cho lập trình.

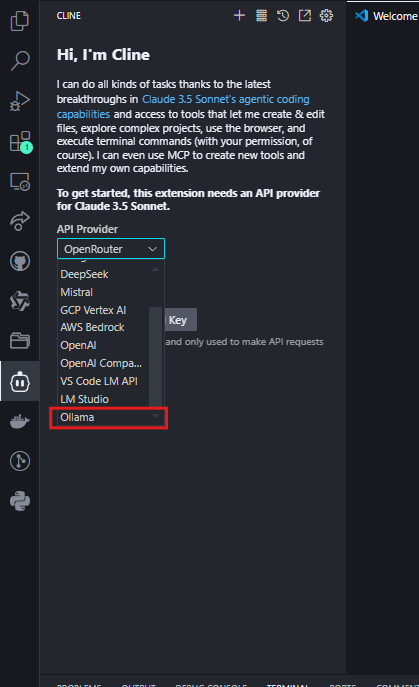

- Cấu hình Cline:

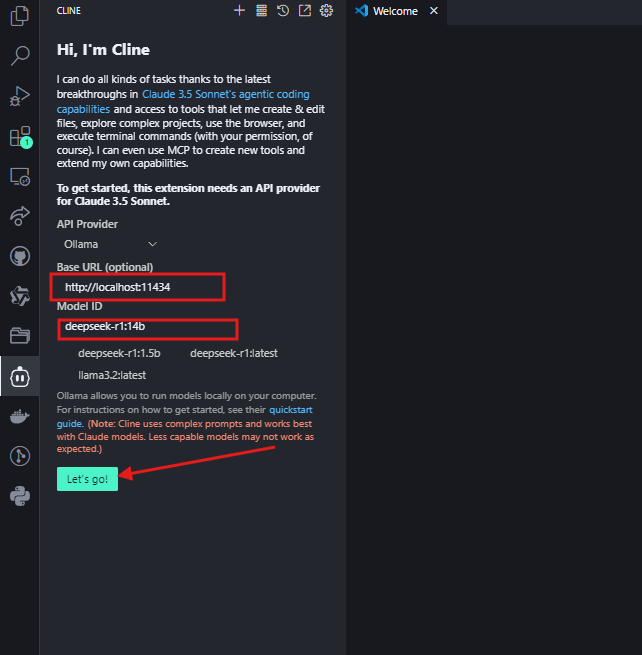

- Đặt Nhà cung cấp API thành “Ollama”.

- Nhập

http://localhost:11434làm Base URL và chọn mô hình của bạn (ví dụ,deepseek-r1:14b).

Nhấn “Lets go” và bạn có thể sử dụng nó ngay bây giờ.

Tùy chọn B: Tích hợp OpenRouter (Chuyển đổi mô hình linh hoạt)

Đối với các nhà phát triển muốn truy cập vào nhiều mô hình AI (bao gồm DeepSeek R1) thông qua một khóa API duy nhất, OpenRouter cung cấp một giải pháp hợp lý. Điều này lý tưởng nếu bạn thỉnh thoảng cần so sánh các kết quả đầu ra với các mô hình như GPT-4 hoặc Claude nhưng muốn DeepSeek R1 làm mặc định của mình.

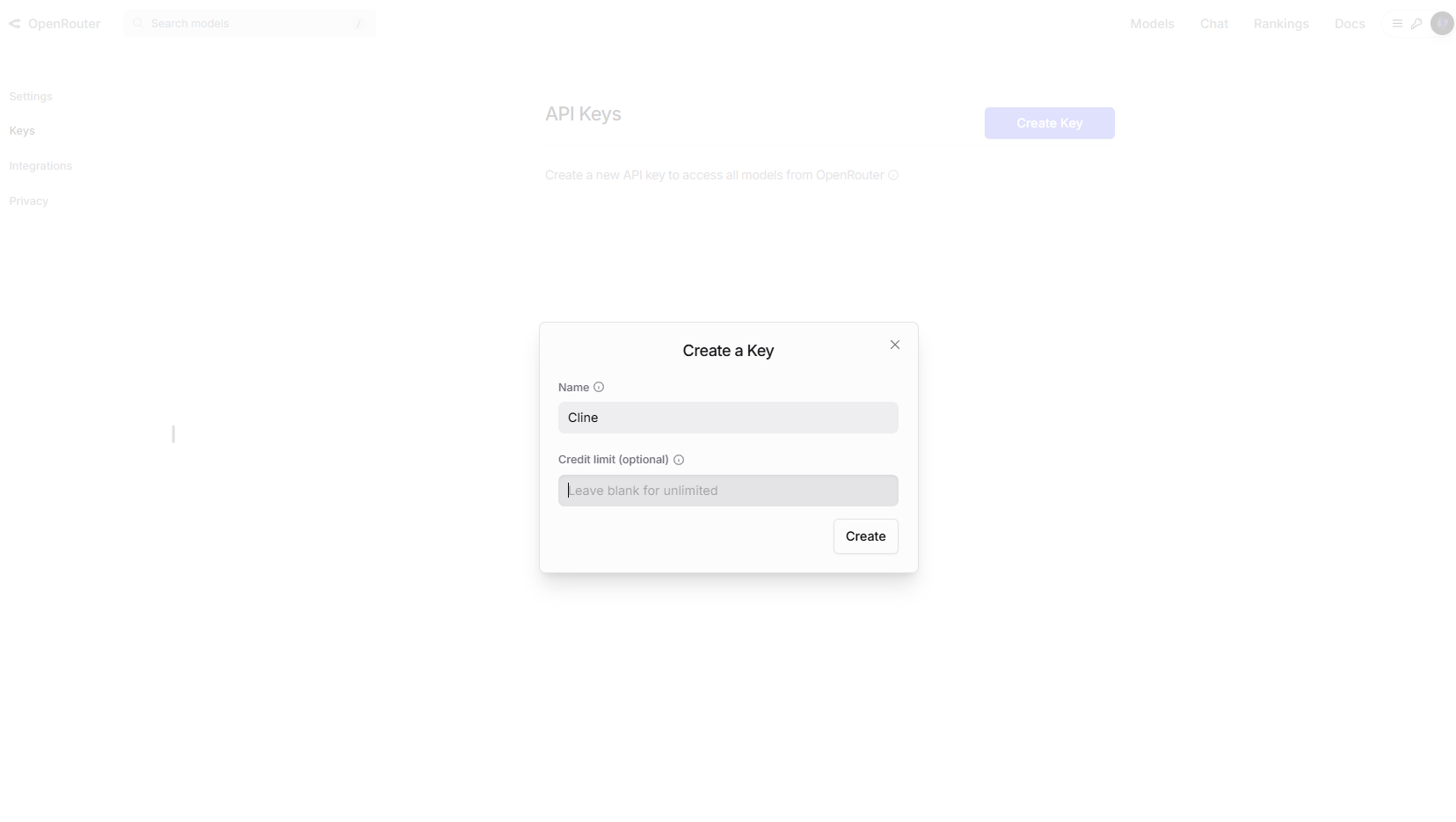

Bước 1: Nhận Khóa API OpenRouter của bạn

- Truy cập OpenRouter.ai và đăng ký.

- Điều hướng đến Các khóa API và tạo một khóa mới.

Tùy chọn: Bật giới hạn chi tiêu trong cài đặt tài khoản để kiểm soát chi phí.

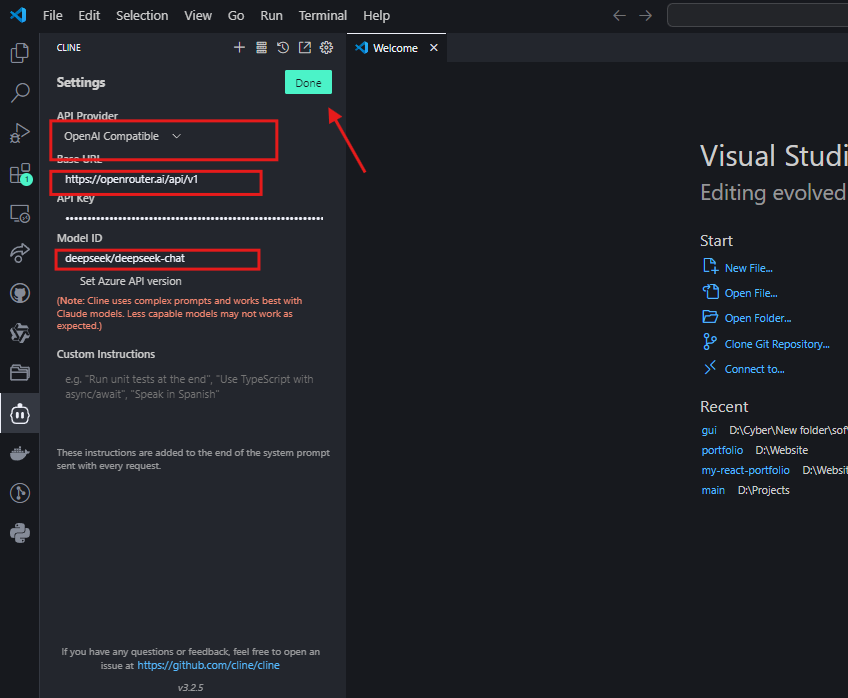

Bước 2: Cấu hình Cline cho OpenRouter

- Trong VS Code, mở cài đặt của Cline.

- Chọn “Tương thích OpenAI” làm nhà cung cấp API.

- Đặt Base URL thành

https://openrouter.ai/api/v1. - Dán khóa API OpenRouter của bạn.

- Trong trường ID mô hình, nhập

deepseek/deepseek-chat

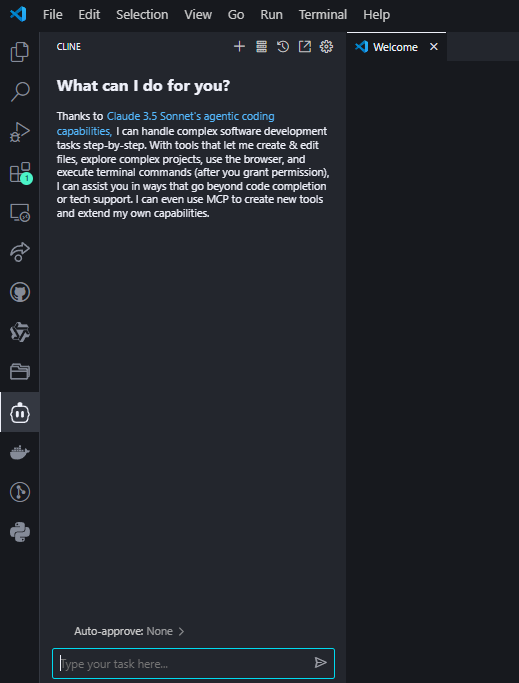

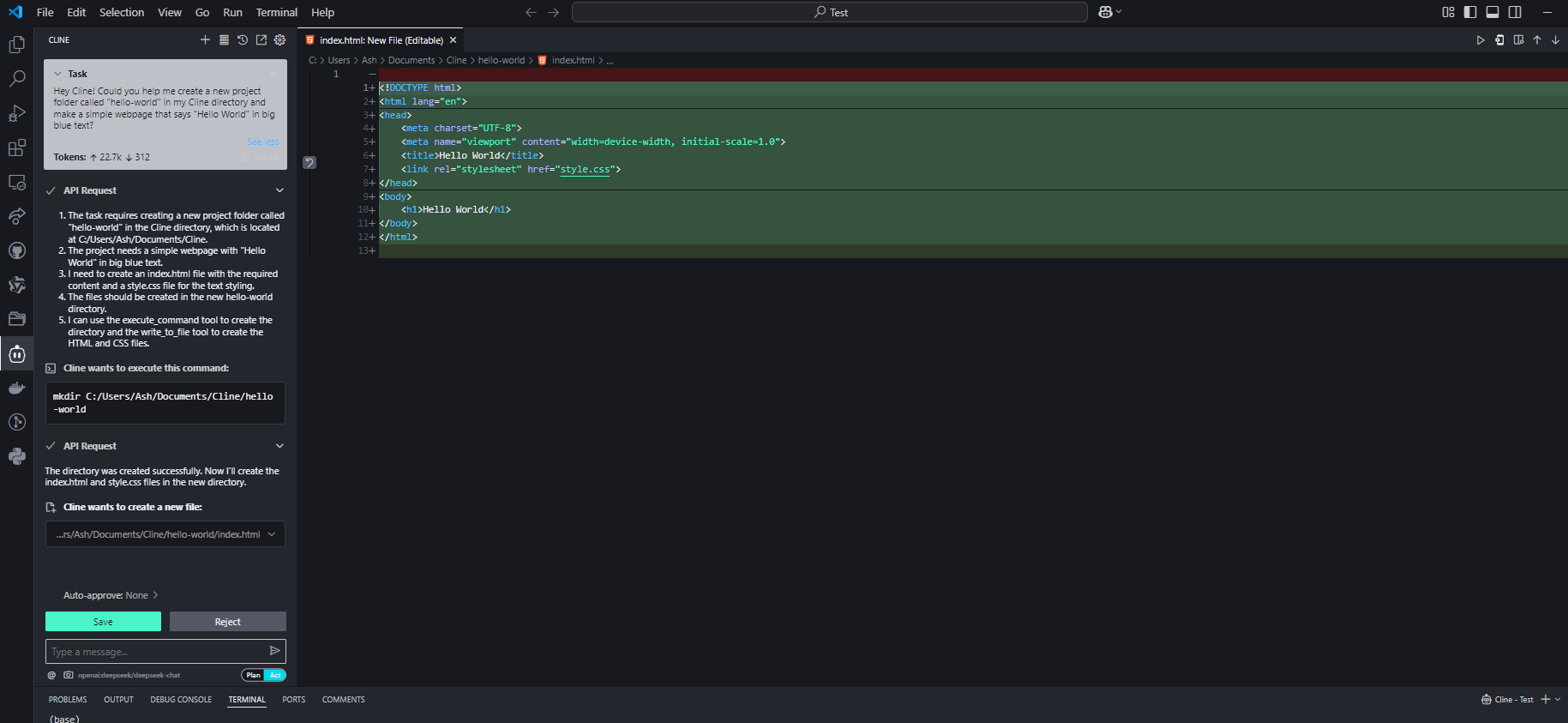

Bước 3: Kiểm tra Tích hợp

Hỏi Cline một câu hỏi lập trình để xác nhận thiết lập:

Nếu được cấu hình đúng, DeepSeek R1 sẽ tạo mã với các giải thích trong giao diện của Cline.

Tại sao chọn OpenRouter?

- Truy cập nhiều mô hình: Dễ dàng chuyển đổi giữa DeepSeek R1 và 50+ các mô hình khác (ví dụ, GPT-4, Claude) mà không cần cấu hình lại API.

- Minh bạch chi phí: Theo dõi việc sử dụng token trên tất cả các mô hình trong một bảng điều khiển.

- Hỗ trợ dự phòng: Tự động chuyển hướng yêu cầu đến các mô hình sao lưu nếu API của DeepSeek R1 bị quá tải.

Xem xét chi phí

Trong khi mức giá của OpenRouter cho DeepSeek R1 gần giống với chi phí API trực tiếp (~$0.01 cho mỗi triệu token đầu vào), luôn kiểm tra trang giá cả của họ để biết tỷ lệ theo thời gian thực. Đối với người dùng nặng, việc lập hóa đơn hợp nhất của OpenRouter có thể đơn giản hóa quản lý chi phí.

Mẹo chuyên nghiệp để tối ưu hóa hiệu suất

1. Kích thước mô hình so với phần cứng

| Mô hình | RAM cần thiết | GPU khuyến nghị |

|---|---|---|

| 1.5B | 4GB | Tích hợp |

| 7B | 8–10GB | NVIDIA GTX 1660 |

| 14B | 16GB+ | RTX 3060/3080 |

| 70B | 40GB+ | RTX 4090/A100 |

Mẹo: Các mô hình định lượng (ví dụ: Q4_K_M.gguf) giảm 30% việc sử dụng VRAM mà không làm giảm chất lượng nhiều.

2. Kỹ thuật xây dựng lệnh

- Đối với mã: Bao gồm các hướng dẫn rõ ràng như “Sử dụng Python 3.11 và type hints”.

- Đối với gỡ lỗi: Dán nhật ký lỗi và hỏi “Giải thích lỗi này và sửa chữa nó”.

Khắc phục sự cố thường gặp

1. Phản hồi chậm

- Khắc phục: Chuyển sang một mô hình nhỏ hơn hoặc bật tăng tốc GPU trong Ollama với

OLLAMA_GPU_LAYERS=12.

2. Ảo giác hoặc câu trả lời lệch lạc

- Khắc phục: Sử dụng các lệnh chặt chẽ hơn (ví dụ: “Trả lời chỉ bằng bối cảnh đã cung cấp”) hoặc nâng cấp lên các mô hình lớn hơn như 32B.

3. Cline bỏ qua ngữ cảnh tập tin

- Khắc phục: Luôn cung cấp đường dẫn tập tin đầy đủ (ví dụ:

/src/components/Login.jsx) thay vì các tham chiếu mơ hồ.

Bài viết này thực hiện (hoặc lụm bài về đăng câu like từ các trang khác) bởi Việt Lâm Coder một YOUTUBER có tâm và đẹp trai siêu cấp vô địch zũ trụ. Các bạn đi ngang nếu được cho Lâm 1 like và 1 đăng ký kênh Youtube nhé !!

Bài viết này thực hiện (hoặc lụm bài về đăng câu like từ các trang khác) bởi Việt Lâm Coder một YOUTUBER có tâm và đẹp trai siêu cấp vô địch zũ trụ. Các bạn đi ngang nếu được cho Lâm 1 like và 1 đăng ký kênh Youtube nhé !!